Claris FileMaker 2025(ファイルメーカー)の新機能!ローカルLLMを標準機能で動かしてみよう

URL: https://www.claris.com/ja/blog/2025/announcing-the-2025-release-of-claris-filemaker

はじめに

以前の記事で「ローカルLLM OllamaをFileMakerで試してみる」という方法をご紹介しましたが、2025年7月9日にリリースされたClaris FileMaker 2025では、ついにオンプレミス環境でローカルLLMを標準で利用できるようになりました。

このアップデートにより、これまで必要だった「Ollama」や「LM Studio」といったツールの個別インストールが不要になり、より手軽にローカルLLMとの連携機能が実現できます。

ローカルLLMとは?

ローカルLLM(Local Large Language Model)とは、クラウドサーバー上ではなく、自社のPCやサーバといったローカル環境で直接動作させる大規模言語モデルのことです。インターネット接続が不要でオフライン環境でも利用できる点が大きな特徴です。

ローカルLLMのメリット

- 高いセキュリティ : データを外部に送信しないため、情報漏洩のリスクを大幅に低減できます。

- オフライン利用 : インターネット接続がない環境でも問題なく動作します。

- 高速なレスポンス : 通信の遅延がなく、リアルタイム性の高い処理が可能です。

- 柔軟なカスタマイズ : 自社の業務データに合わせてモデルの調整が容易です。

- コスト削減 : クラウドサービスのAPI利用料などがかからず、長期的なコストを抑えられます。

環境

OS: Windows Server 2022

Claris FileMaker Server: 22.0.1.66

Claris FileMaker Pro: 22.0.1.68

STEP1: サーバ側の設定

まずは、Claris FileMaker ServerでAI機能を利用するための準備を行います。

Hugging Faceでアクセストークンを取得

AIモデルのダウンロードは、AIモデルの共有プラットフォームである「Hugging Face(ハギングフェイス)」から行います。そのため、まずはアカウントを作成し、アクセストークンを取得しましょう。

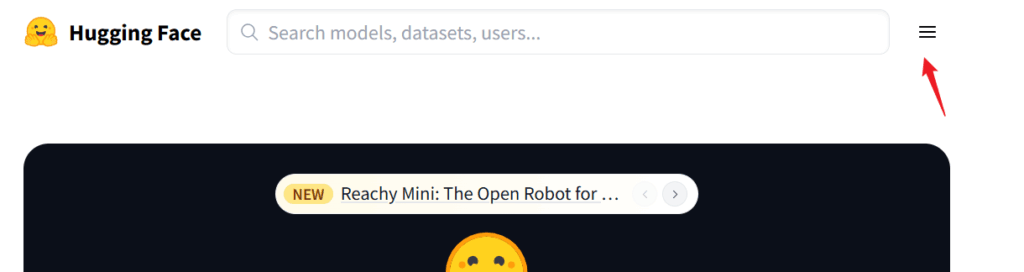

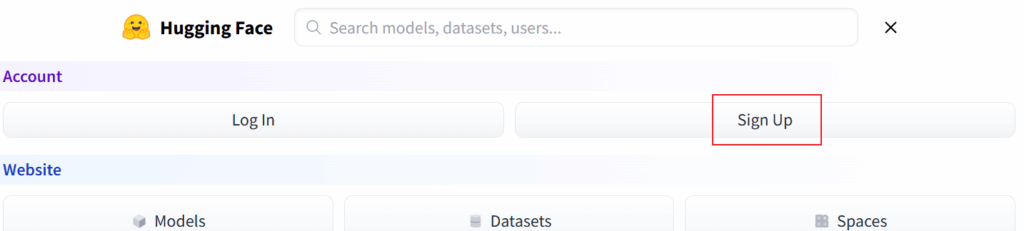

- Hugging Faceサイトへアクセス

https://huggingface.co/ にアクセスし、「Sign Up」からアカウントを登録します。

- アクセストークン作成

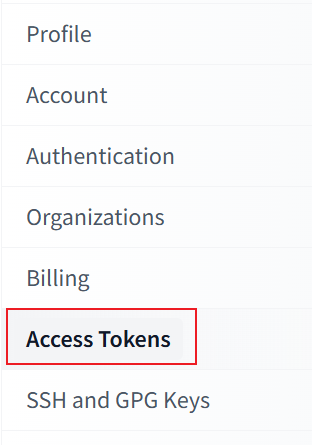

ログイン後、「Access Tokens」メニューを選択します。

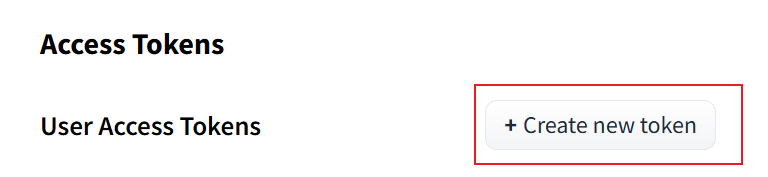

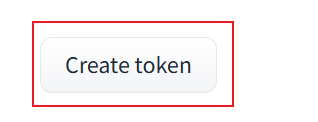

「Create new token」をクリックし、任意のトークン名を入力してトークンを作成します。

- トークンをコピー・保存

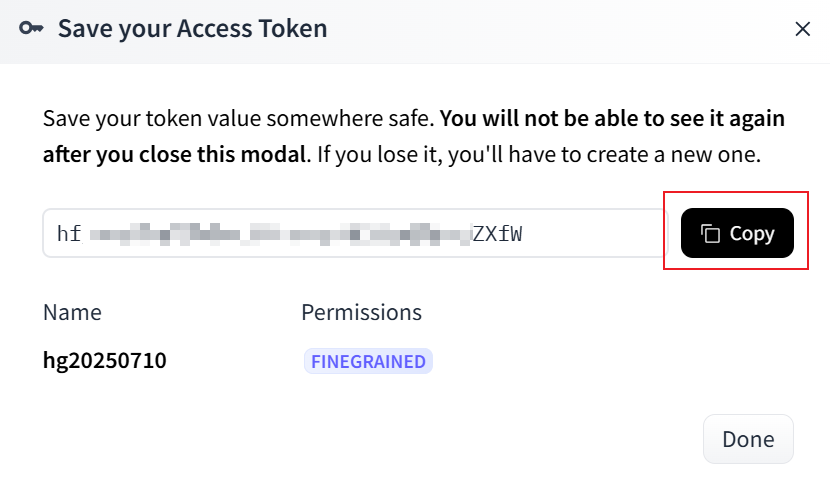

生成されたアクセストークンは、この画面でしか表示されません。必ず「Copy」ボタンでコピーし、安全な場所に保管してください。

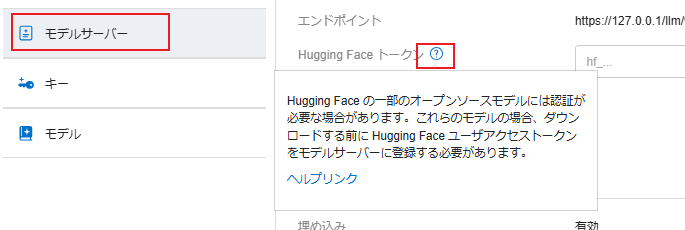

取得したアクセストークンは後ほどAdmin Consoleの「モデルサーバー」のHugging Face トークンに設定します。

依存モジュールのインストール

次に、AIモデルを動作させるために必要なモジュール(Miniforge)をインストールします。

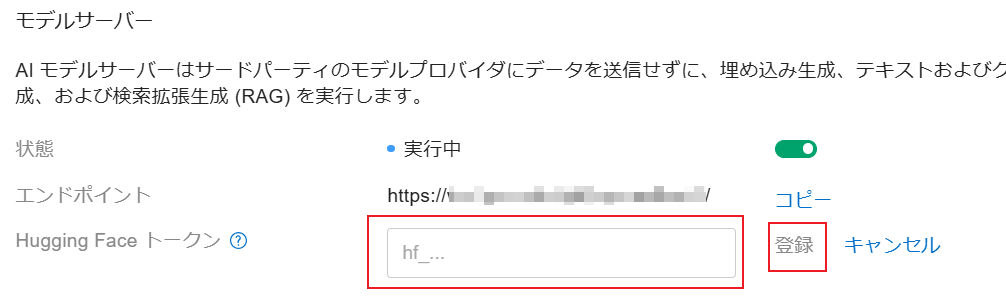

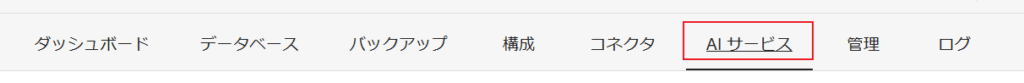

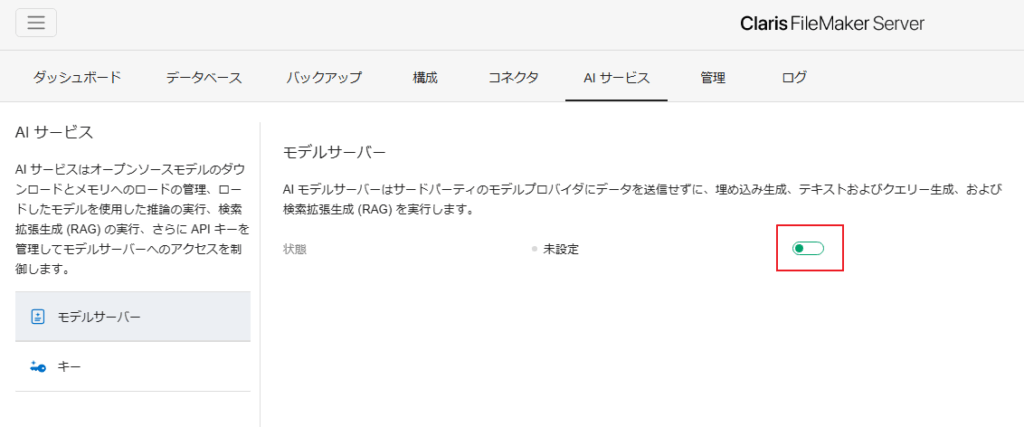

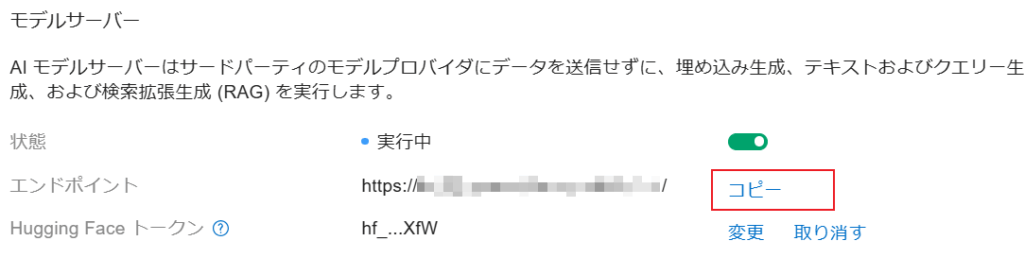

- モデルサーバーの設定を開始

Admin Consoleの「AIサービス」タブを開き、「モデルサーバー」を有効にします。

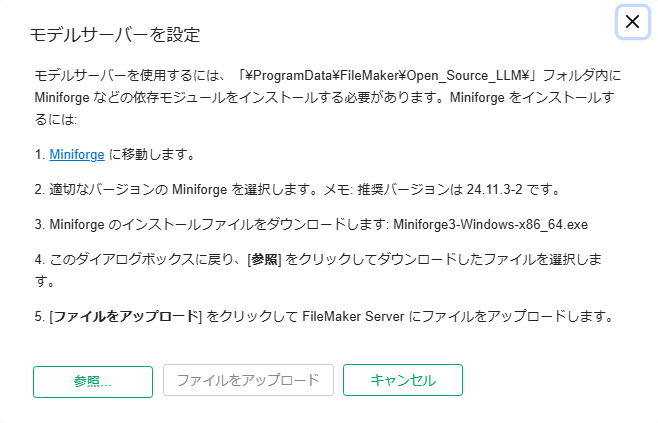

- Miniforgeのダウンロード

表示されるダイアログの指示に従い、Miniforgeのダウンロードページへ移動します。

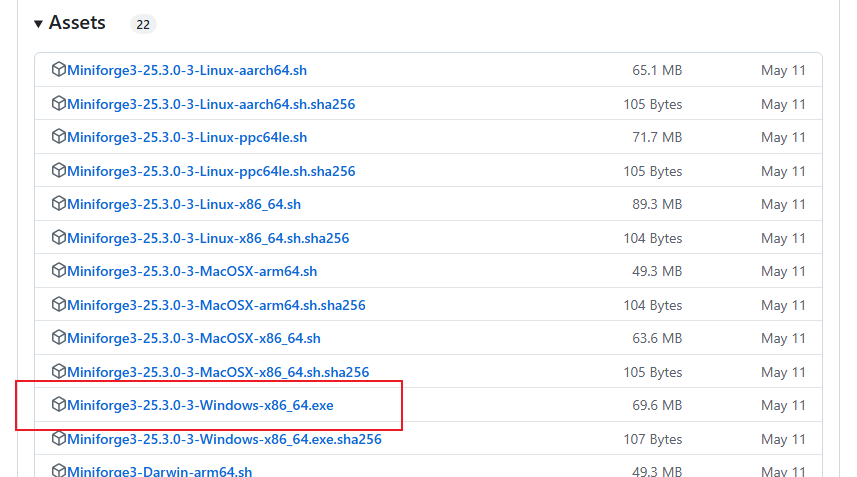

Windows環境の場合、「Miniforge3-25.3.0.3-Windows-x86_64.exe」をダウンロードします。(記事記載時点)

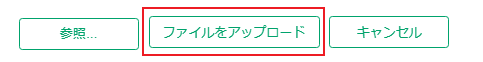

- ファイルのアップロード

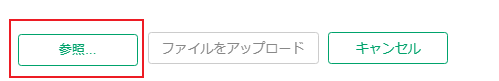

Admin Consoleの画面に戻り、「参照」ボタンからダウンロードしたファイルを選択し、「ファイルをアップロード」をクリックします。

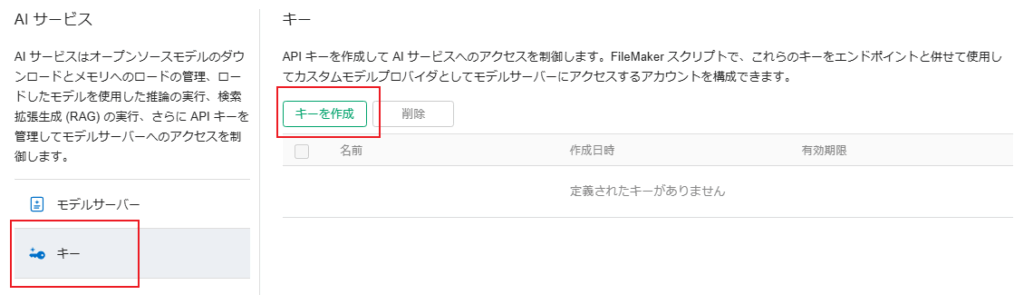

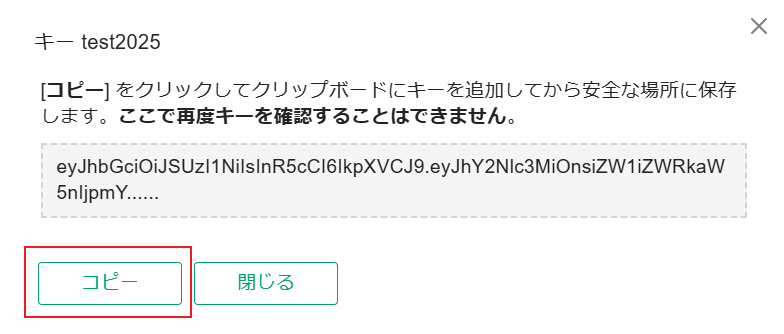

APIキーの作成

AIモデルへアクセスするための専用の「鍵」となるAPIキーを作成します。

- Admin Consoleの「AIサービス」>「キー」で「キーを作成」ボタンをクリックします。

任意の名前、許可するサービス(例: テキストおよびクエリ生成)、有効期間を設定して保存します。

作成されたAPIキーが表示されたら、必ず「コピー」ボタンでコピーし、安全な場所に保管してください。 このキーも再表示はできません。

【スクリプト用情報】

ここでコピーしたAPIキーは、後でFileMakerスクリプトの$api_key変数に設定します。

モデルの選定と追加

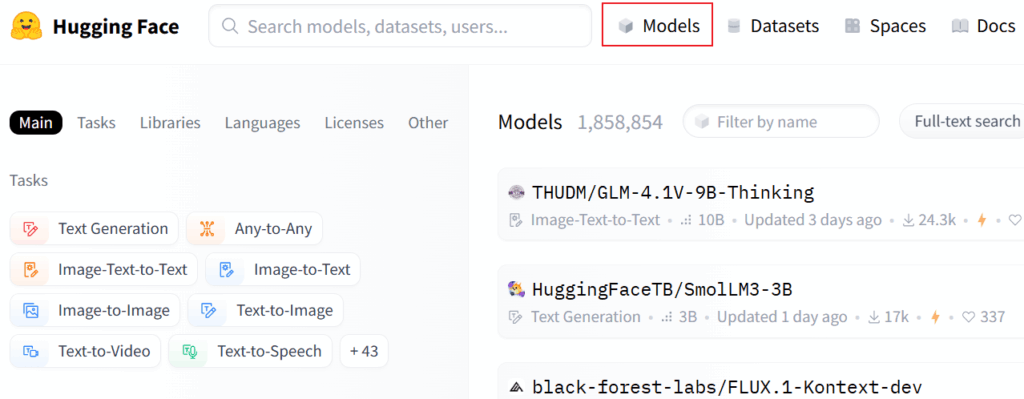

使用したいAIモデルをHugging Faceから選び、サーバに追加します。

- モデルの選択

https://huggingface.co/models から利用したいモデルを探し、モデル名を控えます。

(例 : waowao/gemma3-1b-it-oasst2-1k_of_33k-ja)

※注意 : モデルごとにライセンスが異なります。必ず利用条件を確認してください。

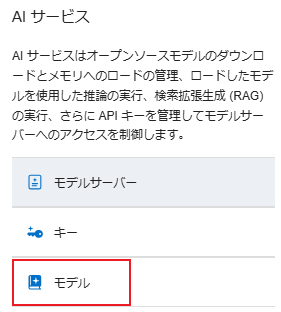

- モデルの追加

Admin Consoleの「AIサービス」>「モデル」で「モデルを追加」ボタンをクリックします。

控えておいたモデル名とモデルタイプを指定し、許可するチェックを入れて追加します。

※モデルタイプは「?」のヘルプを参照してください。

【スクリプト用情報】

ここで指定したモデル名は、後でFileMakerスクリプトの$model変数に設定します。

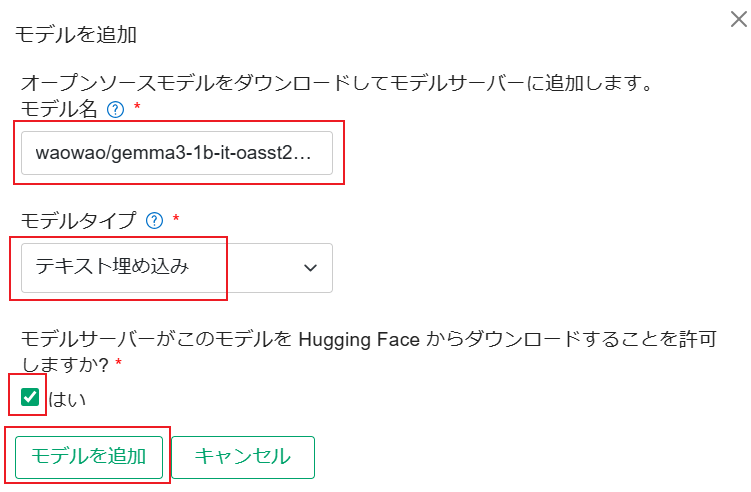

エンドポイントの確認

最後に、スクリプトから接続する際に必要となるエンドポイント(接続先)のURLをコピーします。

- Admin Consoleの「AIサービス」>「モデルサーバー」画面で、エンドポイントの横にある「コピー」ボタンを押して控えておきます。

【スクリプト用情報】

ここでコピーしたエンドポイントは、後でFileMakerスクリプトの$endpoint変数に設定します。

以上でサーバ側の準備は完了です。

STEP2: FileMaker Proからの接続設定

次に、Claris FileMaker ProからAIモデルを利用するためのスクリプトを設定します。新しく追加された2つのスクリプトステップを使用します。

*注意:このデモでは、サーバ負荷の軽いLLMで検証しており、サーバスペックによっては、サーバ自体がダウン、もしくは動作しないことがありますのでご注意ください。

AIアカウント設定

「AIアカウント設定」スクリプトステップで、どのAIサーバに接続するかを定義します。

スクリプトステップ:

AI アカウント設定 [アカウント名:$account; モデルプロバイダ:カスタム; エンドポイント:$endpoint; API キー:$api_key]

設定項目:

- アカウント名 : 任意の名前を変数($account)で指定します。

- モデルプロバイダ : カスタムを選択します。

- API キー : コピーしたAPIキーを変数($api_key)で指定します。

- エンドポイント : コピーしたURLを変数($endpoint)で指定します。

モデルから応答を生成

「モデルから応答を生成」スクリプトステップで、実際にAIに質問を送り、応答を受け取ります。

スクリプトステップ:

モデルから応答を生成 [アカウント名:$account; モデル:$model; ユーザプロンプト:llm::input_text; 応答: llm::output_text]

設定項目:

- アカウント名 : 上記で設定したアカウント名の変数($account)を指定します。

- モデル : モデル名を変数($model)で指定します。

- ユーザプロンプト : 質問内容を入力するフィールドを指定します。

- 応答 : AIからの回答を格納するフィールドを指定します。

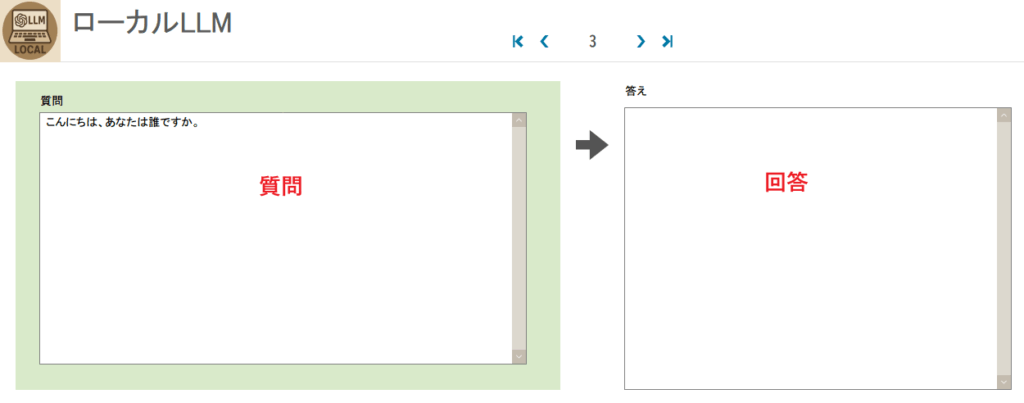

実行結果

設定したスクリプトを実行し、「こんにちは、あなたは誰ですか。」と質問したところ、無事にローカルLLMから応答を得ることができました。

【重要】パフォーマンスに関する推奨事項

Claris FileMaker Server 2025には、ローカルLLMを簡単に組み込む機能が実装されましたが、快適な運用のためには注意点があります。

高性能なAIモデルは、多くのコンピュータリソース(CPU、メモリ、GPU)を消費します。そのため、Clarisの公式エンジニアリングブログでは、AIサービスをメインのFileMaker Serverとは別の専用サーバで実行することが強く推奨されています。

Claris公式のエンジニアリングブログ(en)

Running Your Own AI Model Server

https://support.claris.com/s/article/Get-Claris-FileMaker-Server-2025-ready-for-apps-with-AI?language=en_US

ベストプラクティス:

- 本番環境では、AIモデル専用のサーバーマシンを用意する。

- プライマリのClaris FileMaker ServerではAIサービスを稼働させず、データベース機能に専念させる。

もし同一マシンで運用する場合は、パフォーマンスへの影響を十分に考慮してください。

【参考】

上のエンジニアリングブログでダウンロードできる「Running_Your_Own_AI_Server-Guide-PDF.pdf」ではさらに

- AIモデルサーバーの導入と利点

- ハードウェア要件とリソース

等、さらに詳細なFileMaker AIサービスサーバーを自分で運営するためのハードウェアとインフラの選択に関するガイドが記載されています。

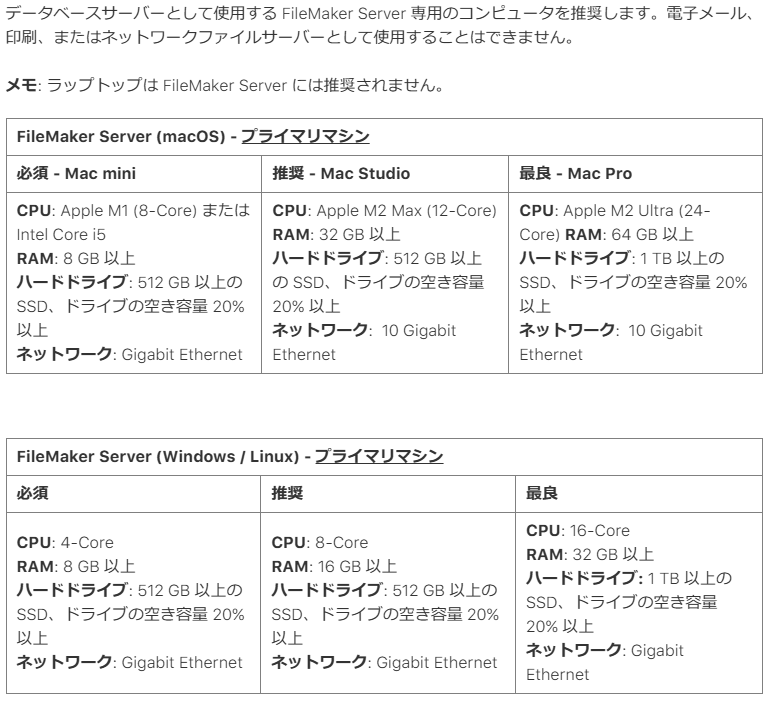

FileMaker Server 22.x のハードウェアの必要条件

AI Model Serverを動作させるために必要なシステム要件

最低必要スペックをみてみましょう。これらの最小要件は、より大きなモデルをフル精度で動作させ、関連するレベルのユーザー負荷がある場合には不十分であることに注意してください。

| Windows & Ubuntu | macOS | |

| Text / Image Embedding Only | CPU: Intel Xeon or AMD Zen 4, 5 series, with AVX2, or AVX512 RAM: 16 GB | CPU: Apple silicon RAM: 16 GB |

| Text Generation | CUDA GPU が必要 CPU: Intel Xeon or AMD Zen 4, 5 series, with AVX2, or AVX512 GPU: Nvidia RTX 4090 or Nvidia A10, with combined VRAM of 32 GB or more VRAM: 32 GB モデルのサイズと量子化に依存する | CPU: Apple silicon Ultra GPU: included (Unified) RAM: 64 GB |

| Fine Tuning | Not supported | CPU: Apple silicon Ultra RAM: 64 GB |

引用 : Running_Your_Own_AI_Server-Guide-PDF.pdf P.12

まとめ

Claris FileMaker 2025では、ローカルLLM連携が標準機能として搭載され、よりセキュアで手軽なAI活用が可能になりました。

今回ご紹介した機能のほかにも、「自然言語での検索実行」や「RAG(検索拡張生成)」など、様々なAI関連機能が追加されています。

ぜひ、これらの新機能を活用して、業務の可能性を広げてみてください。

▼ Claris FileMaker 2025関連記事

- 【2025年最新】FileMaker ライセンスの変更点を徹底解説!

- 文章で検索できる!!Claris FileMaker(ファイルメーカー)2025の自然言語検索がすごすぎた

- 【新機能】GetTextFromPDF関数でPDFを劇的進化!Claris FileMaker(ファイルメーカー)2025

参考サイト

- Running Your Own AI Model Server

https://support.claris.com/s/article/Get-Claris-FileMaker-Server-2025-ready-for-apps-with-AI?language=en_US - FileMaker で AI やってみた (1) - 準備編

https://www.claris.com/ja/blog/2025/fm-ai-1 - FileMaker で AI やってみた (2) - テキスト編

https://www.claris.com/ja/blog/2025/fm-ai-2