ローカルLLM OllamaをFileMaker(ファイルメーカー)で試してみる

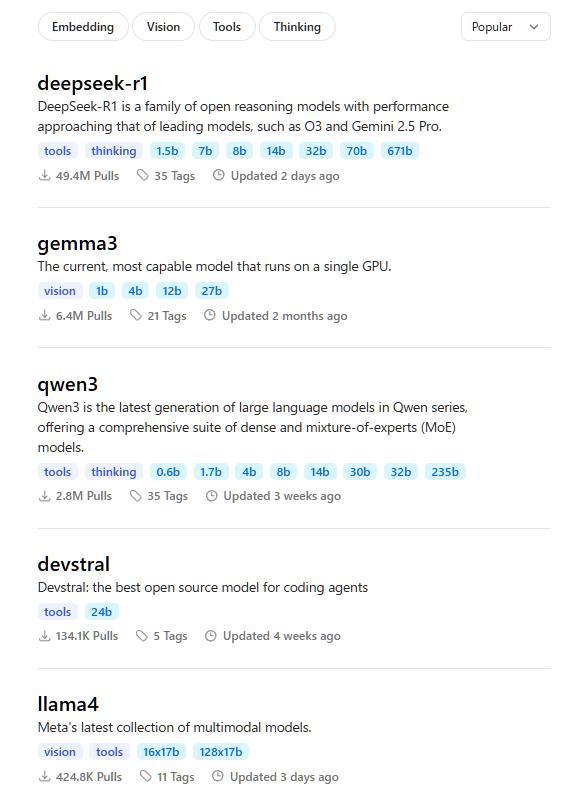

URL : https://ollama.com/search

ローカルLLM

ローカルLLM(Local Large Language Model)は、クラウド上ではなく、自分のPCや自社サーバーなどのローカル環境で直接動作させる大規模言語モデルのことです。従来のLLMはクラウド経由で利用されることが多いですが、ローカルLLMはインターネット接続なし、完全オフライン環境でも利用できるのが特徴です。

ローカルLLMのメリット

- データのセキュリティ・プライバシーが向上し、情報漏洩リスクを大幅に低減できる

- インターネット接続が不要で、オフライン環境でも利用可能

- レスポンスが速く、通信遅延がないためリアルタイム性が高い

- 自社の業務やデータに合わせたカスタマイズやファインチューニングが容易

- 長期的なコスト削減が可能(API利用料やクラウド利用料が不要)

ローカルLLMについては、Claris エンジニアリングブログの「FileMaker 2024 で LLM を利用する」にも記載がありますが、もっと簡単にローカルLLMが導入出来そうな「Ollama」(オラマ)を試してみます。

Llama3 や Gemma2 、OpenAI o1に匹敵するといわれた「DeepSeek-R1」も利用できます。

今回インストールするサーバーはFileMaker Server と同じマシンとします。(Ollamaを他のマシンにイントールしてアクセス可能にする設定についてはふれません)これらについて知りたい場合は下記を参照ください。

LLMをローカルで動かす方法:Ollamaで最小構成からスタート

https://rabiloo.co.jp/blog/run-llm-on-local

環境

OS : Windows Server 2022

Claris FileMaker Server : 21.1.4.400

Claris FileMaker Pro : 21.1.1.41

本記事では、

1. Ollamaのインストール

2. FileMakerProからの接続

について解説いたします。

目次

Ollamaをインストールする

インストール

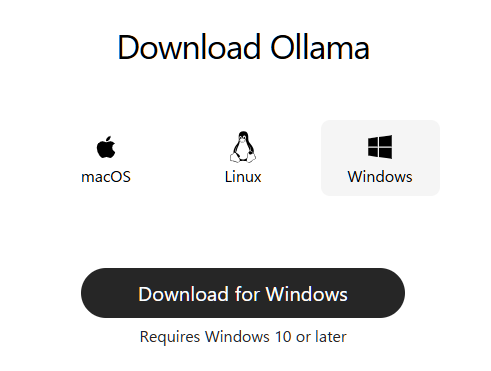

https://ollama.com/downloadからインストーラーをダウンロードできます。

画面の指示に従ってインストールを完了させます。

モデルのインストール

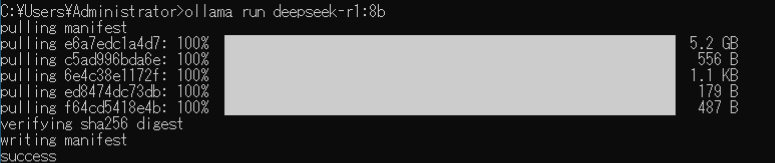

次に、Deepseek-R1のモデルをインストールします。

コマンドプロンプトで「ollama run deepseek-r1:8b」を実行します。

*容量を抑えるため最小のモデルのインストールにしています。実際に使用される際には用途に応じて適切なモデルを選択してください。

日本語に最適化されたモデルのインストール

日本語に最適化されたモデルも多数あります。例えば下記のコマンドで可能です。

「ollama run hf.co/bluepen5805/DeepSeek-R1-Distill-Qwen-14B-Japanese-gguf:Q5_K_M」

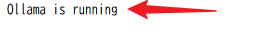

Ollamaサーバーの稼働確認

ブラウザから「http://192.168.11.73:11434」と指定して、「Ollama is running」と表示されることを確認します。

* 192.168.11.73 には サーバーマシンのIPアドレスを指定します。

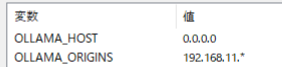

[参考]他のPCにインストールしたOllamaを参照したい場合

ユーザー環境変数に下記を指定して再起動ます。(未検証)

FileMaker Proから接続してみる

URLから挿入

「URLから挿入」スクリプトステップを使用して呼び出します。

url : http://192.168.11.73:11434/api/generate

model : deepseek-r1:8b

json :

JSONSetElement ( "{}" ;

[ "model" ; $model ; JSONString ] ;

[ "prompt" ; ollama::input_text ; JSONString ] ;

[ "stream" ; "false" ; JSONBoolean ]

)cURLオプション :

"--location --header \"Content-Type: application/json\"

--data @$json -D $header"実行してみる

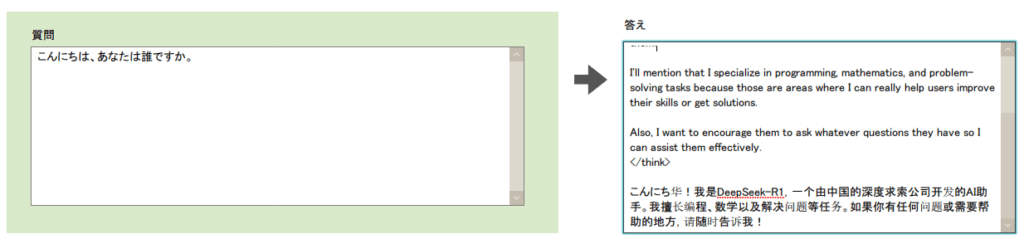

「こんにちは、あなたは誰ですか。日本語で回答してください。」と質問した回答が下記になります。

日本語がおかしいですね。

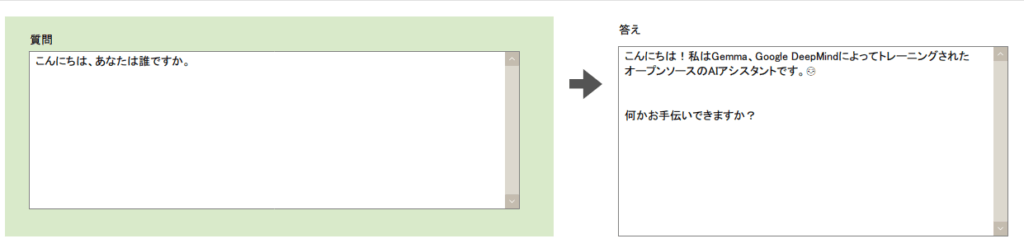

モデルを「hf.co/alfredplpl/gemma-2-2b-jpn-it-gguf」にした場合が下記になります。

使用するモデルは用途に応じて選択します。下記URLからどのようなモデルがあるか確認できます。

https://ollama.com/search

より高性能なモデルを使用したい場合、それに比例してPCのスペックも高くする必要があります。

まとめ

Claris エンジニアリングブログの「FileMaker 2024 で LLM を利用する」の内容を見て挫折した方も「Ollama」であれば自分でもインストールしてみようと思われたのではないでしょうか。

「Ollama」は商用利用も可能なオープンソースですがライセンスについては必ず確認するようにしてください。また、利用するモデル自体のライセンスも確認するようにしてください。

参考サイト

LLMをローカルで動かす方法:Ollamaで最小構成からスタート

https://rabiloo.co.jp/blog/run-llm-on-local